Eine robuste pSEO-Datenpipeline aufbauen

Eine praktische Anleitung zum Aufbau von Datenpipelines, die von 100 bis 100.000 Seiten skalieren ohne zu brechen.

Überblick

Deine programmatische SEO-Seite ist nur so gut wie deine Daten. Diese Anleitung behandelt wie du eine Datenpipeline baust, die zuverlässig, skalierbar und wartbar ist.

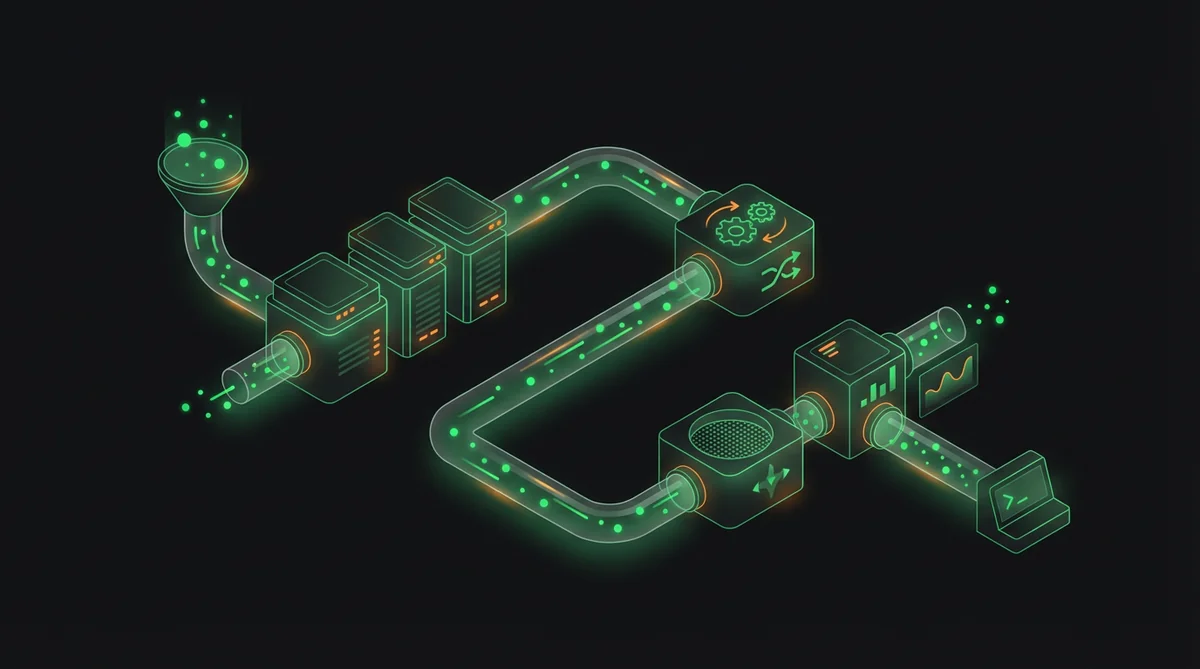

Pipeline-Architektur

Kernkomponenten

- Datenquellen: APIs, Scraper, manuelle Eingaben

- Ingestion-Layer: Sammlung und Normalisierung

- Speicherung: Datenbank mit korrekter Indexierung

- Verarbeitung: Anreicherung, Validierung, Deduplizierung

- Output: API für dein Frontend/SSG

Empfohlene Architektur

Quellen → Ingestion (Airflow/Cron) → PostgreSQL → Validierung → API → SSG BuildSchritt 1: Daten-Ingestion

API-Ingestion

- Nutze Rate Limiting um API-Limits zu respektieren

- Implementiere exponentielles Backoff bei Fehlern

- Logge alle Requests für Debugging

- Cache Responses um API-Calls zu reduzieren

Web Scraping

- Respektiere robots.txt und Rate Limits

- Nutze rotierende Proxies für Skalierung

- Handle dynamischen Content (Playwright/Puppeteer)

- Überwache auf Strukturänderungen

Schritt 2: Datenspeicherung

Schema-Design

- Normalisiere für Konsistenz

- Indexiere Spalten die in Queries verwendet werden

- Nutze JSONB für flexible Attribute

- Tracke updated_at für Frische

Beispiel-Schema

CREATE TABLE entities (

id SERIAL PRIMARY KEY,

slug VARCHAR(255) UNIQUE NOT NULL,

name VARCHAR(255) NOT NULL,

category_id INTEGER REFERENCES categories(id),

attributes JSONB,

status VARCHAR(50) DEFAULT 'draft',

created_at TIMESTAMP DEFAULT NOW(),

updated_at TIMESTAMP DEFAULT NOW()

);Schritt 3: Datenvalidierung

Validierungsregeln

- Vollständigkeit: Erforderliche Felder vorhanden

- Format: URLs valide, Daten parsebar

- Business-Logik: Preise positiv, Ratings 1-5

- Einzigartigkeit: Keine doppelten Entitäten

Qualitätsüberwachung

- Richte Alerts für Validierungsfehler-Spitzen ein

- Tracke Datenfrische pro Quelle

- Überwache auf Duplicate Content

- Regelmäßige Audits von Sample-Seiten

Schritt 4: Automatisierung

Scheduling

- Hochfrequente Daten: Stündliche Updates

- Moderat: Tägliche Updates

- Statische Daten: Wöchentlich/monatlich

Tools

- Einfach: Cron Jobs

- Mittel: GitHub Actions

- Komplex: Apache Airflow, Dagster

Schritt 5: Monitoring

Wichtige Metriken

- Pipeline-Erfolgsrate

- Datenfrische (Zeit seit letztem Update)

- Entitäts-Coverage (% mit vollständigen Daten)

- Fehlerraten pro Quelle